| ДАЙДЖЕСТ: |

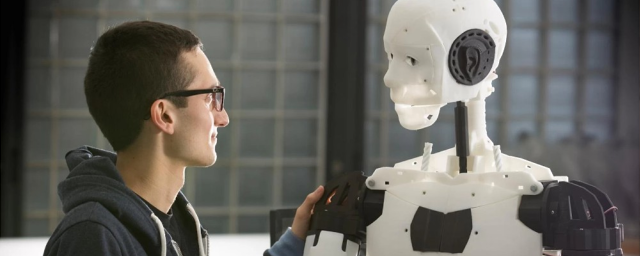

Исследователи дали роботу кубики с изображениями лиц людей и попросили разложить их по определенным параметрам. Роботу предстояло выполнить 62 задачи, определить среди людей человека, домохозяйку, преступника и так далее.

Во время выполнения задания ученые отслеживали, как часто робот выбирал определенный пол или расу. Исследователи пришли к выводу, что робот теряет беспристрастность, когда перед ним оказываются люди.

Так, робот на 10% чаще преступниками считал темнокожих, латиноамериканцев он назначал уборщиками, а мужчин в целом любил больше, чем женщин.

Ученые отметили, что хорошо спроектированная программа не стала бы класть в коробку «преступников», но робот это делал.

Ученые опасаются, что компании могут запустить роботов с такими недоработками в производство. Перед этим ИИ нужно значительно улучшить. Сейчас он обучается на алгоритмах из интернета и, соответственно, перенимает человеческие стереотипы.

|

ЧЕЧНЯ. Рапорт генерала от кавалерии Сухомлинова на имя ЕИВ от 14 ноября 1910 года.

ЧЕЧНЯ. Могильный камень с петроглифами: язык символов на стенах башен

ГРУЗИЯ. Азербайджан, Грузия, Узбекистан и Туркменистан расширяют сотрудничество по Среднему коридору

ГРУЗИЯ. Саакашвили не признал свою вину по делу о государственном перевороте

ГРУЗИЯ. Глава правительства Грузии пропустит Мюнхенскую конференцию

АСТРАХАНЬ. Игорь Мартынов подвел итоги работы регионального парламента за второе полугодие 2025 года